自从2019年MoCo横空出世,掀起了一股自监督学习的浪潮,随后SimCLR,MoCo,BYOL,SwAV等一系列优秀的工作被提出,2021年底,何凯明的MAE更是将自监督学习带到另外一个高度。自监督学习的背后一个强大的动机就是,打破目前神经网络训练对于标注数据的依赖,即使在没有标注数据的情况下,也可以高效的训练网络。自监督学习的核心在于合理构建有利于模型学习的任务,其大致可分为三类:

基于pretext task的自监督学习方法大概有四篇经典的工作:

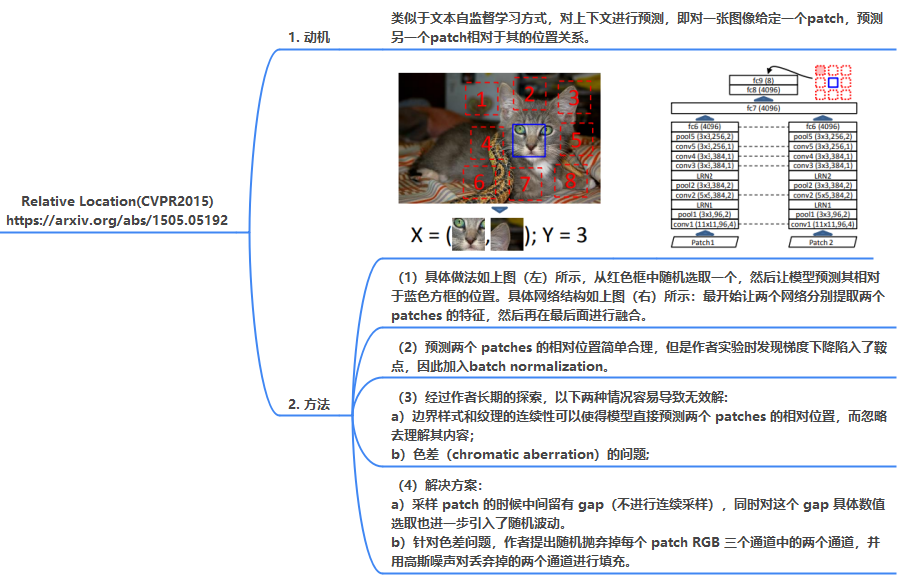

1. Relative Location(CVPR2015)

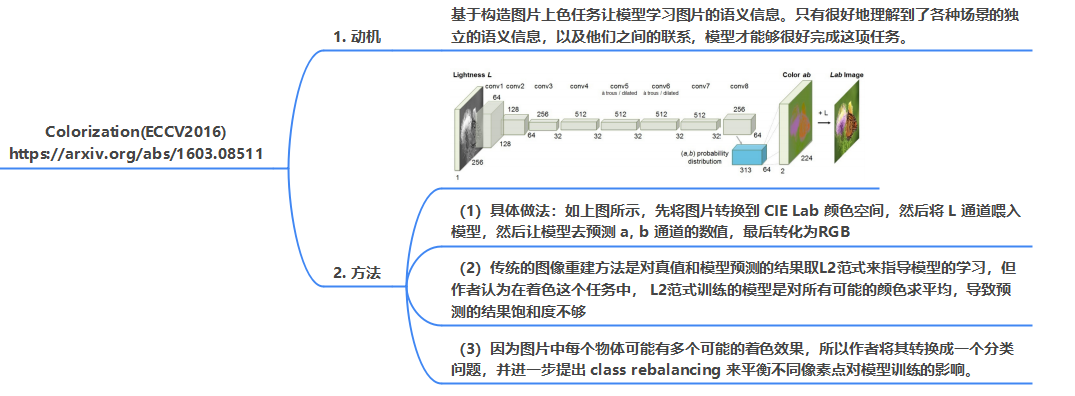

2. Colorization(ECCV2016)

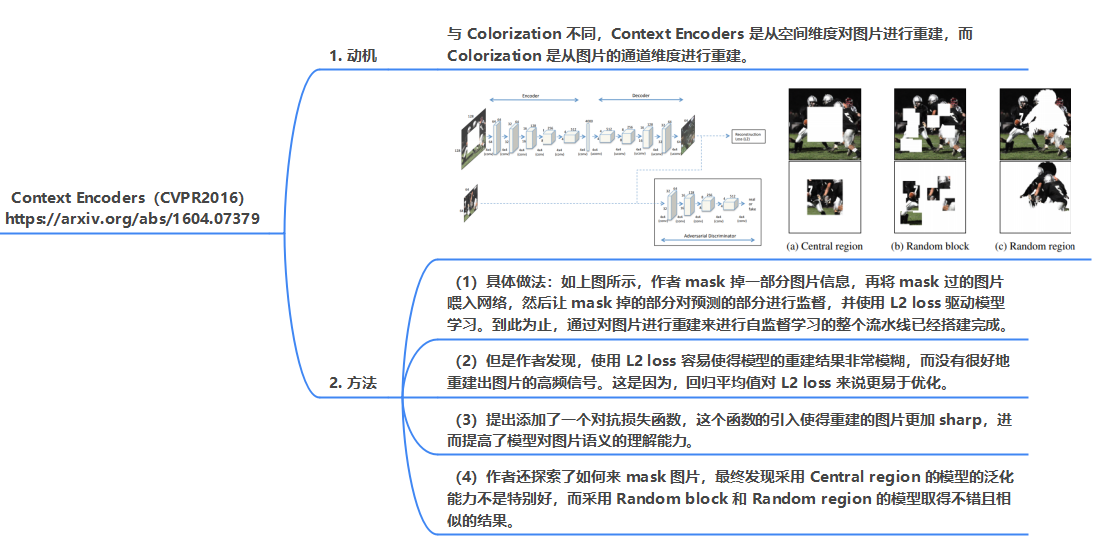

3. Context Encoders(CVPR2016)

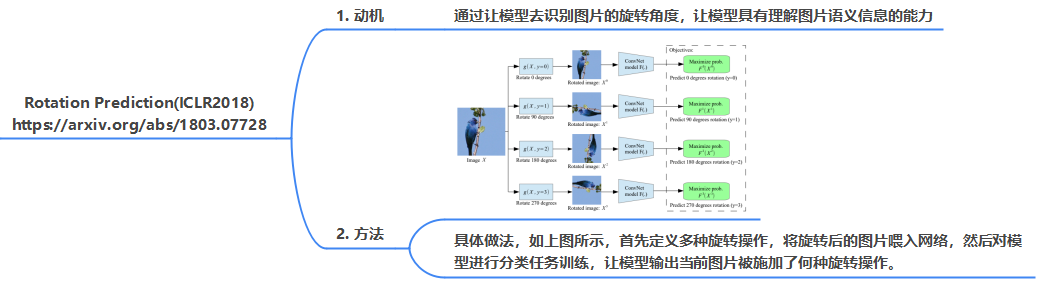

4. Rotation Prediction(ICLR2018)

从上面4种方法可以看出,基于pretext task的自监督学习方法都具备俩个特点:

- 良好的任务定义,比如预测旋转角度,或者相对位置

- 合理的限制条件,避免模型出现无效解